我是 Evan。在做数据采集和反作弊系统的这十几年里,我见过无数工程师和运营人员在“IP 列表”面前崩溃。

当你要查一个 IP 时,随便找个网站输入一下,不到一秒钟就能得到结果。这很简单。但在实际业务场景中——无论是分析服务器的 Nginx 日志、清洗爬虫代理池,还是排查电商订单的欺诈风险——我们要面对的往往不是一个 IP,而是成百上千,甚至上万个 IP 地址。

这时候,手动查询显然是不现实的。你需要的是“批量查询”方案。但我必须提醒你:批量查询不仅仅是把单次查询重复一万次那么简单。 这里面涉及到并发限制、数据清洗、API 成本以及隐私泄露的风险。

在我此前撰写的 IP 地址检测指南 中,我详细介绍了针对单个 IP 的多维度检测标准。而在这篇文章中,我将从实战角度出发,教你如何高效、安全地处理海量 IP 数据,并避开那些 90% 的新手都会踩的坑。

核心决策:批量查询 IP 的正确方式

- IP 数量 < 500:Excel 插件或在线工具即可,成本最低。

- IP 数量 1,000–100,000:必须使用 Python 脚本 + 商业 API 接口。

- 任何规模:查询前必须执行“去重”和“剔除内网 IP”,防止隐私泄露。

- 高频并发:必须配合 代理 IP 池 分散请求,否则极易被封锁 (429 Error)。

目录

- 一、查询前的“数据清洗”

- 二、实战决策:三种批量查询方案的优劣对比

- 三、开发者专栏:使用 Python 批量查询的最佳实践

- 四、警惕!批量查询中 90% 的人会忽略的 3 大风险

- 五、进阶应用:查出来之后,怎么用?

- 六、常见问题解答 (FAQ)

- 七、结语:效率只是基础,视野决定高度

一、查询前的“数据清洗”

很多朋友拿到一堆日志文件或数据库导出表,第一反应就是直接丢进批量查询工具或者写代码调用 API。根据我的经验,这通常是错误的开始。

未经清洗的源数据不仅会浪费你的 API 预算和时间,还会导致查询程序频频报错。在开始查询之前,请务必执行以下三步清洗操作:

1. 去重

这是最基础但也最容易被忽略的一步。在服务器日志或攻击流量记录中,同一个 IP 可能在短时间内出现了几千次。如果你不对列表进行去重(Unique)处理,你不仅多花了 1000 倍的钱,还可能因为对同一个 IP 的高频查询请求,被查询服务商判定为恶意攻击而封禁账号。

Evan 的建议: 即使是 Excel 这样简单的工具,利用“删除重复值”功能,通常也能帮你把 10 万行的数据缩减到几千行。这直接等于帮你节省了 90% 的成本。

2. 格式标准化与“脏数据”剔除

原始数据往往是不干净的。最常见的情况包括:

- 带端口号: 很多日志记录格式为

192.168.1.1:8080。绝大多数 IP 查询 API 都不识别端口号,直接传入会导致查询失败。你需要先用文本处理工具把冒号后面的内容切掉。 - 带协议头: 类似

http://1.1.1.1的格式也是无效的,必须剥离。 - 格式校验: 确保剩下的是合法的 IPv4 或 IPv6 格式。任何包含字母(非 Hex)或乱码的行都应直接丢弃。

3. 剔除内网与保留地址

这是涉及隐私安全的关键一步。在你的服务器日志中,经常混杂着类似 127.0.0.1(本地回环)、192.168.x.x 或 10.x.x.x(局域网)的 IP 地址。

根据互联网工程任务组 (IETF) 发布的权威标准 RFC 1918: Address Allocation for Private Internets,这些地址保留用于私有网络,不在公网路由中传播。

把这些地址发给第三方的在线批量查询工具,不仅查不出任何地理位置(因为它们没有公网归属地),反而会暴露你公司的内网网段架构,增加安全隐患。

如果你不确定哪些是内网 IP,建议对照我整理的 公网与本地 IP 的区分 进行清洗,能有效避免无效查询。

二、实战决策:三种批量查询方案的优劣对比

完成了数据清洗后,我们该用什么工具来查询?根据你的数据量级和技术能力,主要有三种解决方案。为了帮你快速决策,我整理了下面这张决策矩阵:

| 方案类型 | 适用量级 | 精度与时效性 | 技术门槛 | Evan 的点评 |

|---|---|---|---|---|

| 1. Excel 插件 / 在线工具 | 小 (< 500 IP) | 中等(依赖缓存) | 低(无代码) | 适合运营人员临时核对数据,但在处理数万行数据时会卡死。 |

| 2. 离线 IP 数据库 (.mmdb) | 超大 (百万级) | 低到中(取决于更新频率) | 中(需服务器部署) | 速度最快(毫秒级),但无法识别 IP 变动。关于不同数据库的精度对比,请参考 5 款主流 IP 查询工具的精度实测。 |

| 3. 商业 API 接口 | 大 (1万 - 10万) | 高(实时查询) | 高(需写脚本) | 业务系统的首选。虽然有成本,但能获取最新的风险评分和归属地。 |

选型建议: 如果你只是偶尔查几十个 IP,在线工具足够;如果你是开发者,需要构建自动化流程,API 是唯一的出路。

三、开发者专栏:使用 Python 批量查询的最佳实践

当 IP 列表超过 1000 行时,Excel 往往会崩溃,或者让你等到地老天荒。这时候,写一段 Python 脚本调用 API 是最高效的。

但是,很多新手写的脚本经常跑一半就断了。为什么?因为忽略了异常处理 (Error Handling) 和速率限制 (Rate Limiting)。

以下是我常用的一个 Python 代码模板,它增加了重试机制和延时,能保证批量任务的稳定性:

import requests

import time

from typing import List, Dict

def batch_query_ip(ip_list: List[str], api_key: str = None) -> Dict[str, str]:

"""

批量查询 IP 的国家信息

支持的 API:ipinfo.io

"""

results = {}

BASE_URL = "https://ipinfo.io"

# 使用 Session 对象,复用 TCP 连接,提升循环查询的速度

session = requests.Session()

HEADERS = {

"User-Agent": "Mozilla/5.0 (compatible; IPBatchQuery/1.0)",

"Accept": "application/json"

}

# 如果有 API Key,提前注入到 Session 的 header 中

if api_key:

HEADERS["Authorization"] = f"Bearer {api_key}"

session.headers.update(HEADERS)

print(f"开始查询 {len(ip_list)} 个 IP...")

for index, ip in enumerate(ip_list):

try:

url = f"{BASE_URL}/{ip}/json"

# 设置 timeout 很重要,防止某个请求卡死

response = session.get(url, timeout=5)

if response.status_code == 200:

data = response.json()

country = data.get("country", "Unknown")

city = data.get("city", "")

region = data.get("region", "")

# 拼接更详细的地理位置

location_str = f"{country} - {region} - {city}" if city else country

results[ip] = location_str

print(f"[{index+1}/{len(ip_list)}] {ip} -> {location_str}")

elif response.status_code == 429:

print(f"!! 触发速率限制 (429),暂停 60秒... IP: {ip}")

time.sleep(60)

# 简单的重试逻辑:可以考虑在这里递归调用或跳过

results[ip] = "Rate Limited"

elif response.status_code == 403:

print(f"!! 403 Forbidden (可能是Token无效或IP被禁): {ip}")

results[ip] = "Forbidden"

else:

print(f"查询失败 {response.status_code}: {ip}")

results[ip] = f"HTTP {response.status_code}"

except requests.exceptions.RequestException as e:

print(f"请求异常 {ip}: {str(e)}")

results[ip] = "Request Failed"

# 礼貌间隔

time.sleep(0.3)

return results

if __name__ == "__main__":

# 测试数据

ips = ["1.1.1.1", "8.8.8.8", "114.114.114.114", "223.5.5.5"]

# 如果你有 ipinfo 的 token,填在这里,否则传 None

MY_API_TOKEN = None

final_results = batch_query_ip(ips, MY_API_TOKEN)

print("\n--- 最终统计 ---")

for ip, info in final_results.items():

print(f"{ip:15} : {info}")

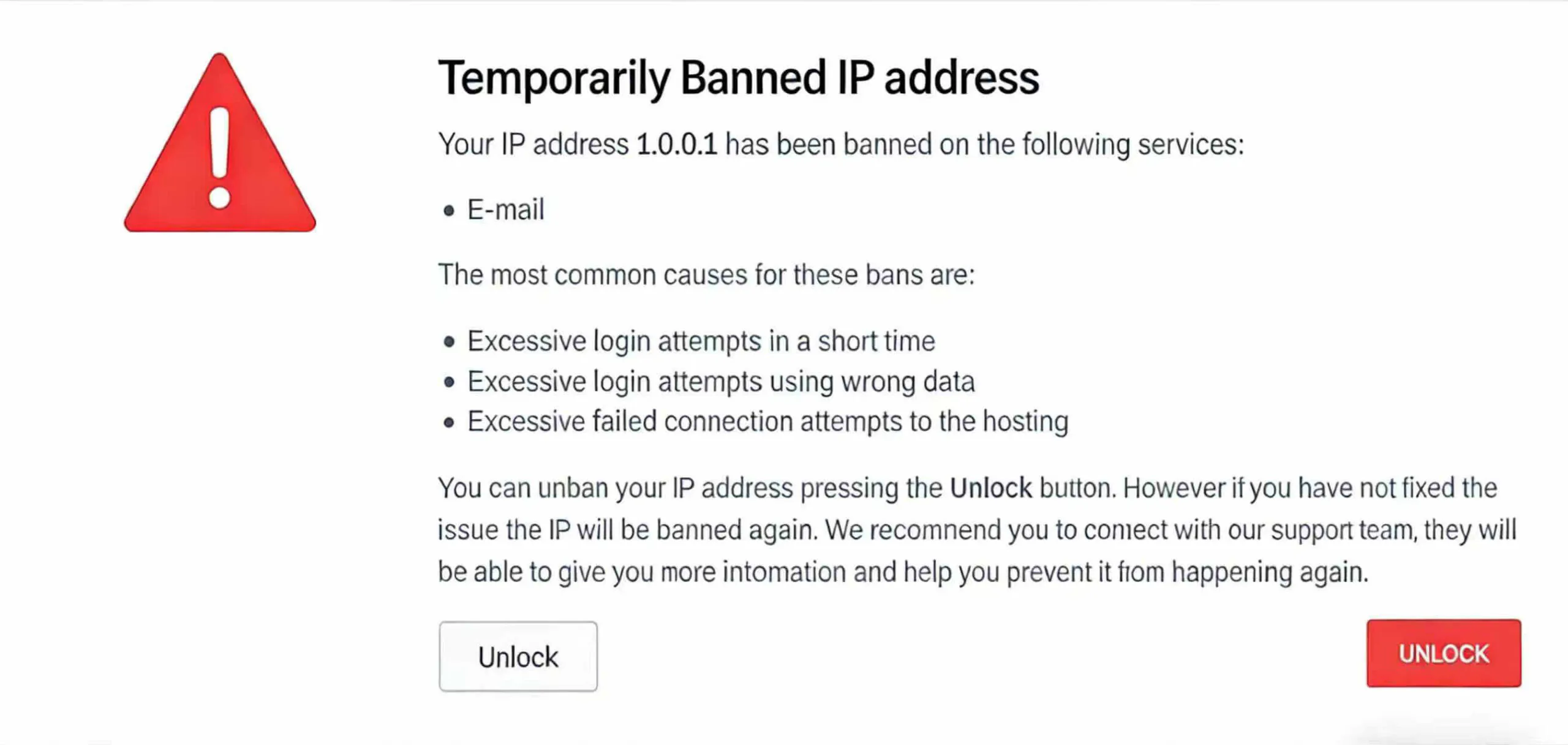

代码解读: 重点在于 time.sleep(0.3)。这符合 IETF RFC 6585 标准中关于 "429 Too Many Requests" 的定义:当用户发送请求过多时,服务器有权拒绝服务以保护资源。如果你不加延迟地暴力循环,你的 IP 很快就会被对方服务器拉黑,导致后续几千个查询全部失败。

四、警惕!批量查询中 90% 的人会忽略的 3 大风险

工具选对了,代码跑通了,是不是就万事大吉了?并非如此。在我和大量企业客户对接的过程中,我发现很多人在批量处理 IP 数据时,往往只盯着结果,却忽视了潜藏的巨大风险。

风险一:隐私泄露与“蜜罐”陷阱

千万不要把你服务器完整的 Access Log(访问日志)直接上传到网上随便搜到的“免费批量 IP 查询网站”。

NIST(美国国家标准与技术研究院)在 SP 800-92 计算机安全日志管理指南 中明确指出,日志文件往往包含敏感的系统配置信息。免费工具中有些本质上就是“数据蜜罐”,它们提供免费查询服务,背地里却在通过收集你的 User-Agent、请求路径甚至业务参数来分析你的网络架构。

风险二:IP 污染与速率限制 (Rate Limiting)

如果你在公司内网直接运行高并发的查询脚本,很有可能会导致全公司的公网出口 IP 被目标查询服务器拉黑(返回 403 或 429 错误)。

这将好比你在短时间内猛敲邻居家的门,邻居不仅不会理你,还会把你列为“骚扰者”。一旦公司的出口 IP 被拉黑,同事们可能连正常的网页都打不开。

因此,进行大规模批量查询时,务必使用代理 IP 池来分散请求压力,将风险分摊到成百上千个不同的出口 IP 上。

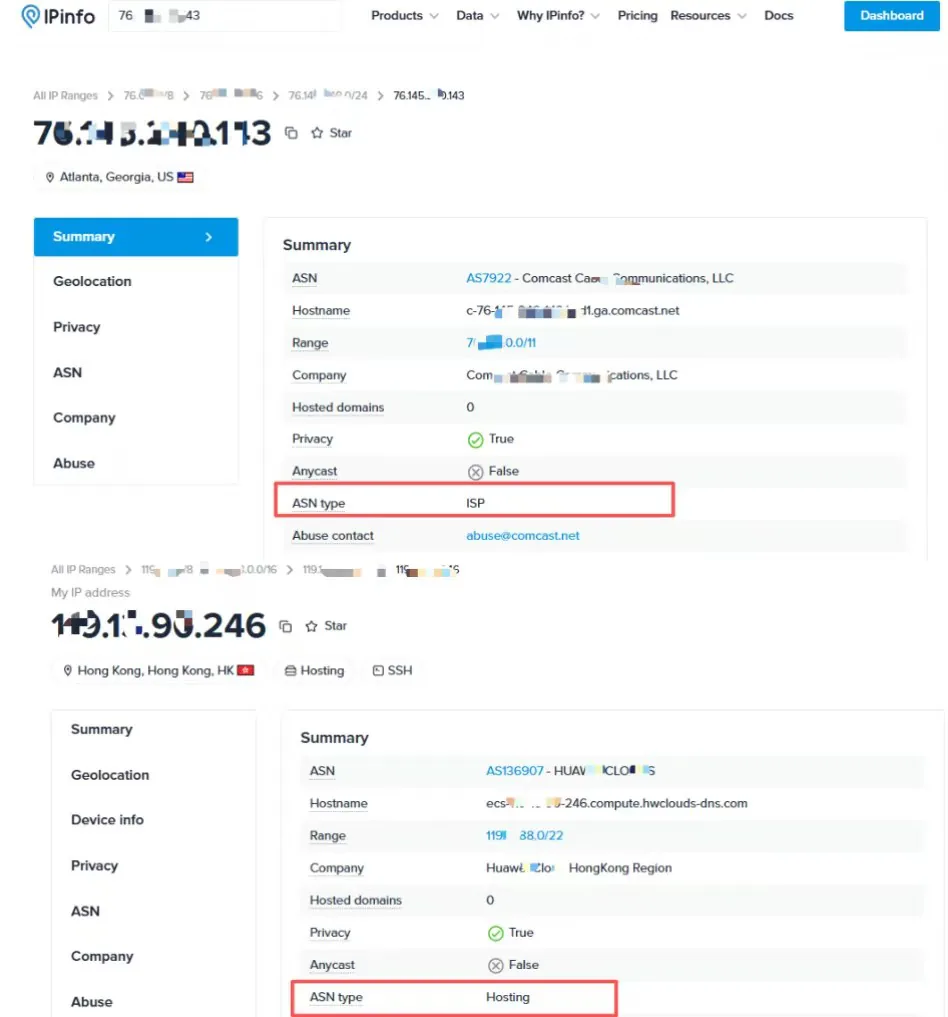

风险三:脏数据误导业务决策

批量查询最怕的不是查不到,而是查错了。很多低质量的数据库分不清“数据中心 IP (Hosting)”和“家庭住宅 IP (ISP)”。

如果你在做反欺诈分析,把一个来自阿里云机房的 IP 误判为真实的家庭用户 IP,你的风控系统就会出现巨大漏洞。关于如何精准识别这两者,我在 住宅 IP 与原生 IP 的识别技术拆解 一文中做了详细分析,建议深入阅读。

五、进阶应用:查出来之后,怎么用?

拿到批量查询的结果(通常是 CSV 或 JSON 格式),并不是工作的结束,而是开始。作为资深从业者,我建议从以下三个维度挖掘数据价值:

- 安全防御 (Geo-Blocking): 在防火墙中导入批量查询结果,直接封禁来自高风险国家(如某些网络攻击频发的特定区域)的所有流量。

- 用户分层与反欺诈: 仅仅知道 IP 在哪个国家是不够的。你需要结合 IP 的“欺诈分数”来判断。例如,一个 IP 虽然显示在美国,但 Risk Score 高达 90 分,这绝对是危险信号。关于分数的具体含义与置信度,请参考 IP 风险评分 (IP Score) 的深度解析。

- 内容分发优化 (CDN): 根据用户的地理位置分布,调整你的 CDN 节点购买策略,把服务器资源花在用户最密集的地方。

六、常见问题解答 (FAQ)

A: 主流商业 API 均已支持,但老旧的免费离线库(如纯真库旧版)通常不支持。务必在购买前查看服务商的覆盖说明。

A: 主要是数据未清洗。你的列表中混入了内网 IP (如 192.168.x.x) 或无效字符,建议先按本文第一章的方法进行清洗。

A: 差距巨大。免费库更新频率低(半年/年),无法反映实时变动;付费 API 通常实时更新,准确率可达 99% 以上。

A: 本地离线库可达每秒数万次;在线 API 受网络限制,通常每秒处理 10-50 个请求。若需更高速度,建议开启多线程并发。

A: 会。如果超过服务商规定的 QPS(每秒请求数)限制,会返回 429 错误。必须在代码中设置延迟 (Sleep) 或使用代理池轮换。

七、结语:效率只是基础,视野决定高度

批量查询 IP 是大数据时代的一项基本功。它即考验你对工具的选择,也考验你对数据的理解。对于真正的专业人士来说,“清洗 -> 查询 -> 分析” 这一整套闭环流程,是保障业务安全的第一道防线。

但解决了“效率”问题后,我们必须面对另一个更复杂的挑战——“地理跨度”。

当你的业务不再局限于本地,而是开始处理来自亚太、欧美甚至全球的流量时,你会发现:适合国内网络的查询逻辑,在跨境场景下完全失效。 延迟增高、数据库更新滞后、甚至是对同一 IP 的归属地判定出现“罗生门”,这些都是跨境业务中常见的深坑。

在我的下一篇专栏文章中,我将把视线投向全球,深入探讨 国外 IP 地址查询的特殊性与跨境误区,帮你打破地域限制,获取真实的全球数据视角。

最后,无论是高并发的批量处理,还是复杂的全球业务拓展,稳定的网络环境永远是基石。如果你在抓取或查询过程中频繁遭遇 429 封锁或连接超时,欢迎体验我们提供的企业级代理 IP 服务,让你的数据采集之路畅通无阻。